Deepfakes-dan – özümüzü necə qoruya bilərik?

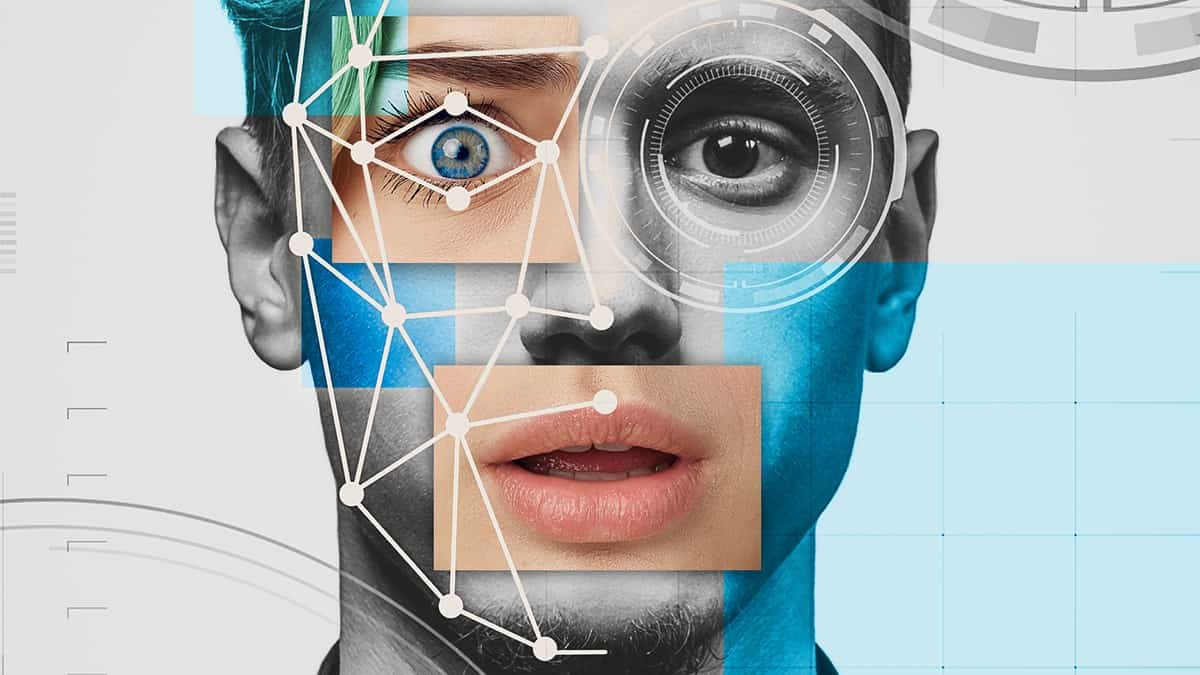

Deepfake, süni intellekt və maşın öyrənməsi texnologiyalarından istifadə edərək, gerçək görüntüləri və ya səsi manipulyasiya edərək yalançı, lakin inandırıcı videolar yaratmaq prosesidir.

Bu texnologiya, insanların üz ifadələrini, bədən dillərini və səsini tamamilə başqa bir insanın üzərinə tətbiq etməyə imkan verir.

Bu məlumatlar daha sonra GAN (Generative Adversarial Network) vasitəsilə Deepfake video yaratmaq üçün işlənə bilər. GAN fərqli bir ixtisaslaşdırılmış maşın öyrənmə sistemidir. Təlim dəstinin müəyyənedici xüsusiyyətlərini (məsələn, insan üzlərinin fotoşəkilləri) öyrənmək və sonra eyni xüsusiyyətlərlə (yeni “şəkillər”) yeni məlumatlar yaratmaq üçün iki neyron şəbəkəsi bir-biri ilə rəqabət aparmaq üçün istifadə olunur.

Belə bir şəbəkə daim yaratdığı şəkilləri məşq dəsti ilə müqayisə etdiyi üçün saxta görüntülər getdikcə daha inandırıcı olur. Bu, Deepfake-i daha da təhlükəli bir təhlükəyə çevirir. GAN-lar foto və videolardan başqa digər məlumatları da saxtalaşdıra bilər. Əslində, eyni Deepfake maşın öyrənmə və sintez üsulları saxta səslər yaratmaq üçün istifadə edilə bilər.

Deepfake nümunələri

Yüksək səviyyəli Deepfake nümunələrini tapmaq çətin deyil. Buna misal olaraq, aktyor Jordan Peele-nin Barak Obamanın öz Obama obrazı ilə birləşmiş real görüntülərindən istifadə edərək Deepfake videolarına qarşı xəbərdarlıq etmək üçün yayımladığı videonu göstərmək olar. Daha sonra aktyor iki yarı ayrıldıqda birləşmiş videonun necə göründüyünü göstərdi. Bəs onun məsləhəti nədir? Gördüklərimizi sorğulamalıyıq.

Facebook-un CEO-su Mark Zukerberqin Facebook-un oğurlanmış istifadəçi məlumatları vasitəsilə “gələcəyi idarə etməsi” haqqında danışan videosu; Üstəlik, Instagram-da var. Orijinal video onun Rusiyanın seçkiyə müdaxiləsi ilə bağlı etdiyi çıxışdan götürülüb. Sözügedən söhbətin cəmi 21 saniyəsi yeni videonu sintez etmək üçün kifayət edib. Bununla belə, onun səsi Jordan Peele-nin Obaması qədər yaxşı deyil və həqiqəti ortaya qoyur.

Deepfake-in zərərləri

Deepfake texnologiyası, bir çox müsbət tərəfləri olsa da, ciddi etik və hüquqi məsələlər yarada bilər:

- Etibar Zədələnməsi: Məşhurlar və ya siyasətçilərin adından yalançı ifadələr yaratmaq, onların reputasiyasını ciddi şəkildə zədələyə bilər.

- Sosial Manipulyasiya: Yalan məlumatların yayılması, ictimai düşüncə və seçimlərə təsir edə bilər.

- Məhkəmə Məsələləri: Deepfake videoları, hüquqi proseslərdə, sübutların saxtalaşdırılması üçün istifadə oluna bilər.

Mühafizə və Mübarizə Yolları

- Texnoloji Alətlər: Deepfake-ləri aşkar etmək üçün yeni süni intellekt alətləri inkişaf etdirilir. Bu alətlər, görüntülərdəki anomaliyaları analiz edir.

- Təhsil və Maarifləndirmə: İctimaiyyətin deepfake-lərin varlığından və onların təsirlərindən xəbərdar olması, yanlış məlumatların yayılmasını azaltmağa kömək edə bilər.

- Hüquqi Tənzimləmələr: Deepfake-lərin qanunsuz istifadəsi ilə mübarizə aparmaq üçün qanunvericilik dəyişiklikləri tələb olunur.

Deepfake, həm müsbət, həm də mənfi potensiala sahib olan bir texnologiyadır. Onun necə istifadə olunacağı, cəmiyyətin, qanunvericilərin və texnologiya mütəxəssislərinin bu sahədə atacağı addımlardan asılıdır. Bu texnologiyanın etik və hüquqi çərçivələrdə düzgün şəkildə idarə olunması vacibdir.

Deepfake-dən özümüzü necə qoruya bilərik?

Artıq Deepfake videolarının yaratdığı təhlükə ilə bağlı qanunlar hazırlanmağa başlayıb. Məsələn, keçən il Kaliforniya ştatında qəbul edilmiş iki qanun layihəsi Deepfakes-dən istifadəni qeyri-qanuni edəcək: AB-602 sözügedən şəxsin razılığı olmadan pornoqrafik məhsullar üçün insan təsvirinin sintezindən istifadəni qadağan edir və AB-730 manipulyasiyanı qadağan edir. Seçkiyə 60 gün qalmış siyasətçilərin görünüşlərini qadağan edir.

Amma bu kifayətdirmi? Xoşbəxtlikdən kibertəhlükəsizlik şirkətləri daim daha çox və daha yaxşı aşkarlama alqoritmləri yaradırlar. Bu alqoritmlər video təsviri təhlil edir və “imitasiya” prosesi zamanı baş verən dəqiqəlik təsvir artefaktlarını müəyyən edir. Məsələn, mövcud Deepfake sintezatorları 2D üzü modelləşdirir və sonra həmin təsviri videonun 3D perspektivinə uyğunlaşdırmaq üçün dəyişdirir. Burnun hansı istiqamətə yönəldiyinə baxmaq vacib bir ipucudur.

Deepfake videoları hələ də ipuçlarını özünüz kəşf edə biləcəyiniz mərhələdədir. Deepfake videolarına xas olan aşağıdakı xüsusiyyətləri axtarın:

- cəld hərəkətlər

- İşıq bir çərçivədən digərinə dəyişir

- Dərinin rəngini dəyişir

- Qəribə yanıb-sönən hərəkətlər və ya heç yanıb-sönmə

- Dodaq hərəkətləri nitqə uyğun gəlmir

- Şəkildəki rəqəmsal artefaktlar

Bununla belə, Deepfake istehsalı yaxşılaşdıqca, saxta videoları öz gözlərinizlə ayırd etməkdə çətinlik çəkdiyiniz üçün yaxşı kibertəhlükəsizlik proqramından alacağınız yardım artacaq.